در این قسمت تیم کدگیت را با آموزش «فایل robots.txt چیست؟» همراهی کنید. ابتدای این جلسه به معرفی فایل robots.txt خواهیم پرداخت. در ادامه در خصوص نحوه ایجاد آن در سایت و تاثیرات این فایل در سئو صحبت میکنیم. پس با ما همراه باشید تا این فایل را معرفی کنیم. همچنین پیشنهاد میکنیم دیگر آموزشهای ما را مطالعه نمایید:

فایل robots.txt چیست؟

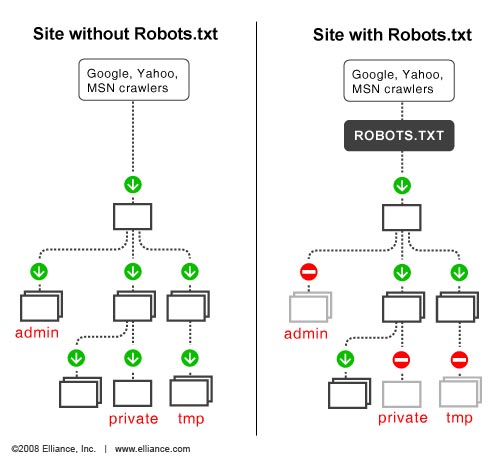

اگر به طور خلاصه بخواهیم کار فایل robots.txt را بگوییم، مدیریت Crawler به سمت صفحات مهم یا دلخواه ما میباشد. از این طریق می توان از بار اضافه(Overloading) درخواستهای(requests) خزشگر(crawler) اجتناب کرد. مدیریت crawler میتواند با اهداف مختلفی انجام گیرد. مثلاً اگر crawler غرق در درخواست به سمت صفحات سایت شما شود یا برای جلوگیری از بازدید و بررسی crawler از صفحات تکراری میخواهید اقدامی انجام دهید، راه آن استفاده از فایل robots.txt است. به همین سادگی پاسخ به پرسش فایل robots.txt چیست را می دهیم.

یک نکته بسیار مهم در خصوص فایل robots.txt باید بدانید این است که از این طریق نمیتوان صفحات سایت را از index گوگل خارج کنید. برای جلوگیری از index صفحات روشهای دیگری مانند تگ noindex، پسورد و … استفاده میشود. از طریق فایل robots.txt تنها میتوان از Crawl جلوگیری کرد.

Robots.txt در وردپرس

بعد از اینکه وردپرس را نصب کردید به صورت اتوماتیک فایل robots.txt در سایت شما ایجاد میشود. این فایل را میتوان ویرایش نمود. برای ویرایش این فایل میتوان از افزونه استفاده کرده و یا از طریق هاست، مستقیم فایل را ویرایش کنید. ما با کمک افزونه Yoast این کار را انجام خواهیم داد.

Yoast

بعد از نصب افزونه Yoast بر روی سایت وردپرسی، وارد SEO قسمت ابزارها شوید.

سپس بر روی گزینه ویرایشگر فایل کلیک کنید:

گزینه ایجاد پرونده robots.txt را انتخاب کنید:

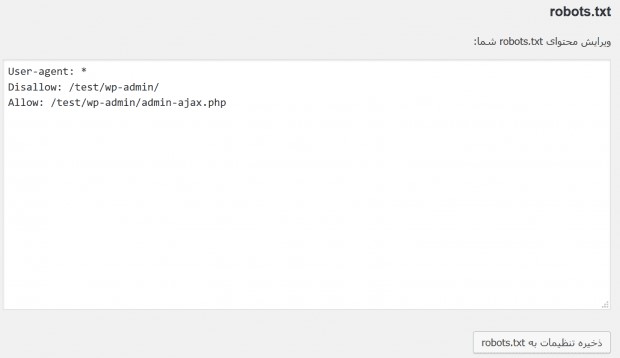

در این قسمت شما میتوانید فایل robots.txt سایت خود را ویرایش کنید.

ویرایش robots.txt

بعد از اینکه از طریق افزونه Yoast، به فایل robots.txt دسترسی پیدا کردید میتوانید آن را ویرایش کنید. دو دستور مهم که در این فایل به کار میرود به صورت زیر است:

- User-agent: نوع ربات از طریق این دستور مشخص میشود. اگر شما میخواهید قوانینی بنویسید که فقط برای ربات گوگل اجرا و برای رباتهای دیگر مانند بینگ و … اجرا نشود میبایست از user-agent استفاده کنید.

- Disallow: این دستور به رباتها اطلاع میدهد که به قسمتی خاص از سایت مجوز دسترسی ندارند.

چند مثال

با ذکر چند مثال فایل robots.txt دلخواه خودمان را ایجاد میکنیم. کد زیر را ببینید:

User-agent:*

Disallow: /

کد بالا بعد از user agent واژه * قرار داده شده که این به معنی همه ربات ها است. بعد از disallow نیز یک / قرار دادهایم این به معنی دامنه اصلی سایت است. یعنی تمامی سایت برای رباتها بسته شده است.

حال به کد زیر رقت کنید:

User-agent: Bingbot

Disallow: /

کد بالا برای ربات بینگ نوشته شده است. این ربات مجوز دسترسی یا خزش سایت را ندارد.

یک قدم جلوتر رفته و حال میخواهیم یک فایل و یا فولدر از سایت را در robots.txt قرار دهیم. برای این کار به کد زیر دقت کنید:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-login.php

فولدر wp-admin و فایل wp-login.php در کد بالا، روبروی دستور disallow قرار دارد. این بدین معنی است که تمامی رباتها این فایل و فولدر را مورد خزش قرار ندهند.

سایت شما اگر قسمتی به عنوان سرچ دارد و میخواهید در Crawler مورد بررسی قرار نگیرد میتوانید از کد زیر استفاده کنید:

User-agent: *

Disallow: /?s=

Disallow: /search/

در کد بالا تمام صفحاتی که در URL آنها پارامتر s= قرار داده شده و یا در فولدر search قرار دارند را محدود کرده است.

به عنوان مثال آخر میخواهیم قانونی را برای دو user agent اعمال کنیم:

User-agent: *

Disallow: /wp-admin/

User-agent: Bingbot

Disallow: /

در کد بالا ابتدا فولدر wp-admin را برای تمامی رباتها بستیم و در ادامه با صدا زدن ربات بینگ، دسترسی کل سایت را برای این ربات محدود کردیم.

چند نکته

در این آموزش با فایل robots.txt و نحوه ایجاد آن آشنا شدیم. در پایان این جلسه چند نکته را جهت یادآوری تهیه کردیم:

- فایل robots.txt ممکن است برای همه موتورهای جستجو کارایی نداشته باشد(برای گوگل و بینگ کار میکنه نگران نباشید!)

- هر crawler ممکن است قوانین خود را داشته باشد و دستورات فایل را به صورت متفاوتی اجرا کند.

- تمامی فایلها و فولدرهایی که disallow شدهاند اگر از جایی به این صفحات لینک شده باشد ممکن است در index گوگل قرار گیرند. اگر میخواهید این صفحات به طور کامل در گوگل حذف شوند میتوانید از فولدرها با پسورد محافظت کرده و یا در header صفحات سایت از تگ noindex استفاده کنید. از این طریق قطعاً گوگل شما را index نخواهد کرد.